Por Hector Luis Lopez

hlopez at geekmagazine.mx

NVIDIA ostenta de manera abrumadora el dominio en la industria del hardware destinada a la inteligencia artificial (IA). Aunque compañías destacadas como AMD, Intel, Google y Amazon rivalizan por obtener una parte significativa del próspero mercado de chips para inteligencia artificial, ninguna de ellas se acerca a la cuota de mercado de la empresa liderada por Jensen Huang. En la actualidad, NVIDIA controla aproximadamente el 80% de esta industria, situándose a una distancia considerable de sus competidores.

Está marcada supremacía se deriva de la capacidad de NVIDIA para anticipar de manera hábil el inminente auge del mercado de chips destinados a la inteligencia artificial. Sin embargo, las proyecciones de los expertos respaldan una conclusión de que los usuarios pueden intuir fácilmente al observar la dirección que están tomando numerosas corporaciones destacadas. Los mencionados anteriormente son solo algunas de estas entidades, pero hay muchas más que están fundamentando su modelo de negocio entorno a la inteligencia artificial. OpenAI, la entidad detrás de la creación de ChatGPT, se encuentra entre estas innovadoras empresas.

La firma consultora TrendForce, ha divulgado un informe sumamente intrigante, donde sostiene que en el futuro OpenAI, necesitará respaldar el motor de inteligencia artificial de ChatGPT con más de 30.000 chips especializados en inteligencia artificial. Este cálculo se basa en la consideración de que la organización empleó alrededor de 20.000 de estos chips desde el año 2020 durante la fase de entrenamiento de su software. Aunque es plausible asumir que OpenAI optará por los chips de última generación de NVIDIA, existe la posibilidad de que algunos clientes de la empresa liderada por Jensen Huang, migren hacia uno de sus principales competidores.

AMD se está abriendo paso a codazos

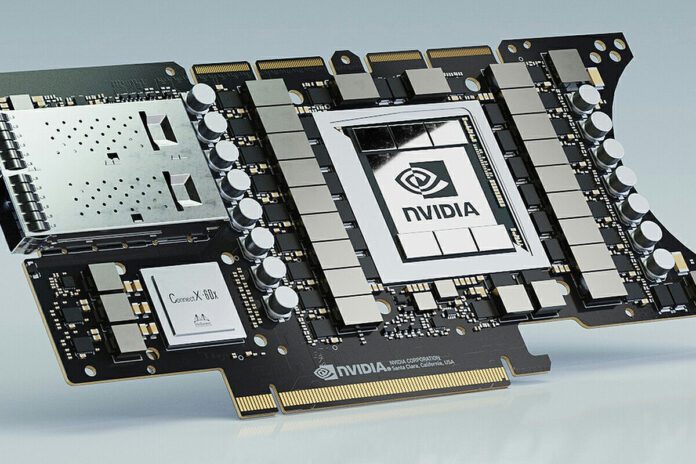

Recientemente, NVIDIA ha lanzado su última incorporación al ámbito de la inteligencia artificial: la GPU H200, catalogada como su chip más potente hasta la fecha. Desarrollada sobre la arquitectura Hopper, esta formidable GPU cuenta con una asombrosa capacidad de 141 GB de memoria VRAM de tipo HBM3E. De acuerdo con los fabricantes, este procesador exhibe el doble de rendimiento en comparación con su predecesor, el chip H100, especialmente en tareas de inferencia necesarias para modelos de lenguajes complejos. Esto sugiere la posibilidad de que en los próximos meses, numerosos clientes de NVIDIA se interesen en adquirir este innovador chip.

Sin embargo, existen diversas alternativas a los chips para inteligencia artificial ofrecidos por NVIDIA y una de ellas destaca significativamente: la GPU MI300X de AMD. Un ingeniero de software especializado en inteligencia artificial en Tesla, Eric Wu, ha observado que la propuesta de AMD supera al chip H100 de NVIDIA tanto en rendimiento por vatio como en rendimiento por dólar. A pesar de contar con casi el doble de transistores que la GPU H100, el chip MI300X es apenas un 25% más grande, gracias a la tecnología de litografía empleada por TSMC en su proceso de fabricación.

A pesar de los desafíos mencionados, NVIDIA posee dos cartas fuertes significativas. La más destacada es CUDA, una plataforma que integra un modelo de programación y un conjunto de herramientas de desarrollo ampliamente adoptadas por numerosas empresas dedicadas a la inteligencia artificial. Descartar CUDA a favor del hardware de AMD u otra compañía sería una transición difícil de aceptar para las empresas que dependen de la infraestructura de NVIDIA. Además, NVIDIA cuenta con el impulso que presumiblemente recibirá con la introducción de la nueva GPU H200. No obstante, es evidente que Jensen Huang y su equipo no pueden permitirse descuidarse si desean mantener la cómoda posición que ocupan actualmente.